AI Updates

ปลดล็อกสมอง AI: Language Concept Models ก้าวสำคัญที่ทำให้ AI คิดเหมือนเรามากขึ้น

AI กำลังก้าวสู่ขั้นใหม่ด้วย Language Concept Models (LCMs) เรียนรู้ว่าโมเดลภาษาเชิงแนวคิดนี้ทำงานอย่างไร แตกต่างจาก LLM เดิมอย่างไร และจะทำให้ AI เข้าใจและคิดได้เหมือนมนุษย์มากขึ้นได้อย่างไร

ช่วงหลายปีที่ผ่านมา เราได้เห็นความสามารถของ AI ในการสร้างสรรค์ข้อความหรือรูปภาพที่น่าทึ่งจนแทบแยกไม่ออกกับสิ่งที่มนุษย์ทำได้ ใช่ครับ กำลังพูดถึง Generative AI ที่มีโมเดลภาษาใหญ่ๆ หรือ LLMs เป็นหัวใจสำคัญนั่นแหละ

LLMs เก่งมากๆ ในการเดาคำถัดไปจากประโยคที่เราให้ไป ลองนึกภาพว่า AI เหมือนนักเดาคำอัจฉริยะที่อ่านมามหาศาลจนรู้ว่าคำไหนควรจะมาต่อจากคำไหน แต่ในอีกแง่หนึ่ง มันก็ยังทำงานอยู่บนพื้นฐานของการเชื่อมโยงคำศัพท์เป็นหลัก ยังไม่ใช่การ "เข้าใจ" ในระดับแนวคิดจริงๆ จังๆ เหมือนสมองคนเรา

แล้วถ้า AI ไม่ได้แค่เดาคำ แต่สามารถ "คิด" และ "เข้าใจ" ในระดับแนวคิดของประโยคได้ล่ะ? นั่นแหละคือสิ่งที่นักวิจัยกำลังมุ่งหน้าไปสู่ กับเทคโนโลยีที่เรียกว่า Language Concept Models หรือ LCMs นี่คือก้าวสำคัญถัดไปที่จะปลดล็อกศักยภาพของ Generative AI ให้ฉลาด ลึกซึ้ง และมีความเข้าใจโลกได้ใกล้เคียงกับมนุษย์มากขึ้น

จาก "เดาคำ" สู่ "เข้าใจแนวคิด" เรื่องมันเป็นมายังไง? ลองจินตนาการว่า LLMs ทำงานเหมือนเรากำลังต่อจิ๊กซอว์ตัวอักษร มันมองชิ้นส่วน (โทเค็น) ที่มีอยู่ แล้วก็เดาว่าชิ้นต่อไปที่เป็นไปได้มากที่สุดคือชิ้นไหน ทำไปเรื่อยๆ ก็ได้ข้อความยาวๆ ออกมา

แต่โลกนี้ซับซ้อนกว่าแค่ตัวอักษร ความหมายจริงๆ มักจะอยู่ในระดับที่สูงกว่านั้น เช่น ประโยค "ฉันรักการอ่านหนังสือ" กับ "การอ่านหนังสือคือความสุขของฉัน" สองประโยคนี้ใช้คำต่างกัน แต่มี "แนวคิด" หลักๆ คล้ายกัน คือ "การอ่านหนังสือ" กับ "ความรู้สึกเชิงบวก/ความสุข"

นี่คือจุดที่ LCMs แตกต่างออกไป แทนที่จะเดา โทเค็น ถัดไปจากชุดโทเค็นที่ได้รับ LCMs จะพยายามทำนาย แนวคิด ถัดไปจากชุดประโยคหรือข้อมูลที่ได้รับ

พูดง่ายๆ คือ LCMs ไม่ได้มองแค่ก้อนอิฐทีละก้อน (โทเค็น) แต่พยายามทำความเข้าใจภาพรวมของอาคาร (แนวคิด) ที่กำลังจะสร้าง ทำให้ AI สามารถคิดในเชิงนามธรรม และมีความเข้าใจที่ลึกกว่าแค่พื้นผิวของคำศัพท์

เบื้องหลังความเข้าใจ: AI มองภาษาเป็น "แผนที่ความคิด" ได้ยังไง? หัวใจสำคัญที่ทำให้ AI ทั้ง LLMs และ LCMs ทำงานได้ คือการแปลงภาษาให้กลายเป็นสิ่งที่คอมพิวเตอร์เข้าใจได้ นั่นคือ Embeddings

ลองนึกภาพว่าโลกของคำศัพท์และประโยคถูกแปลงให้กลายเป็น "แผนที่ความคิด" ที่มีหลายมิติ (เหมือนแผนที่โลก 3 มิติ หรือมากกว่านั้น) แต่ละคำหรือแต่ละประโยคจะกลายเป็นจุดหนึ่งบนแผนที่นี้

คำหรือประโยคที่มีความหมายใกล้เคียงกัน หรือถูกใช้ในบริบทที่คล้ายกัน ก็จะอยู่ใกล้ๆ กันบนแผนที่นี้ การจะรู้ว่าสองประโยคมีความหมายคล้ายกันแค่ไหน ก็ทำได้โดยการวัดระยะห่างหรือมุมระหว่างจุดสองจุดนั้นบนแผนที่นี่แหละ วิธีที่นิยมใช้คือ Cosine Similarity ซึ่งวัดจากมุมระหว่าง "เวกเตอร์" ที่ชี้ไปยังจุดนั้นๆ การมี "แผนที่ความคิด" หรือ Embeddings ที่ดีนี่เอง ที่ทำให้ AI ไม่ได้มองแค่คำว่า "apple" เป็นแค่ตัวอักษร 5 ตัว แต่เข้าใจว่ามันเป็นผลไม้ชนิดหนึ่ง เป็นบริษัทเทคโนโลยี หรืออาจหมายถึงลูกตา ขึ้นอยู่กับว่า "apple" ตัวนั้นอยู่ใกล้กับคำว่าอะไรบนแผนที่ความคิด (อยู่ใกล้ "fruit," "pie," "tree" หรืออยู่ใกล้ "iPhone," "MacBook")

วิวัฒนาการของ "แผนที่ความคิด" (Embeddings): จากนับคำ สู่เข้าใจบริบท

การสร้างแผนที่ความคิด หรือ Embeddings ก็มีพัฒนาการมาเรื่อยๆ

ยุคแรก (Frequency-Based): ง่ายที่สุดคือนับว่าแต่ละคำปรากฏในข้อความบ่อยแค่ไหน วิธีนี้สร้างแผนที่ความคิดได้ง่าย แต่มีข้อจำกัดเรื่องความลึกของความหมายและบริบท เช่น คำว่า "หัว" อาจหมายถึง ส่วนบนสุดของร่างกาย หรือหัวข้อข่าว ซึ่งวิธีนับความถี่อย่างเดียวอาจแยกแยะไม่ได้ยุคถัดมา (Prediction-Based): เป็นการสร้างแผนที่ความคิดที่ซับซ้อนขึ้น โดยใช้โมเดล AI มาช่วยคาดเดาคำที่หายไปในประโยค หรือเดาคำจากบริบทรอบข้าง การทำแบบนี้ทำให้ Embeddings ที่ได้สามารถจับความหมายเชิงบริบทและความสัมพันธ์ระหว่างคำได้อย่างแม่นยำขึ้นมากโมเดลดังๆ ในกลุ่ม Prediction-Based Embeddings ที่เราอาจเคยได้ยินชื่อ เช่น:

Word2Vec (ปี 2013): เป็นก้าวสำคัญที่ทำให้คำที่มีความหมายใกล้เคียงกันอยู่ใกล้กันบนแผนที่ได้อย่างมีนัยสำคัญ (เช่น เวกเตอร์ของ "king" - "man" + "woman" จะได้ค่าใกล้เคียงกับเวกเตอร์ของ "queen")GloVe, ELMo: พัฒนาต่อยอดให้จับบริบทได้ดีขึ้นBERT, ALBERT: โมเดลที่ปฏิวัติวงการ NLP ด้วยการเข้าใจความหมายของคำจากบริบทได้แบบสองทิศทาง (อ่านคำหน้าและคำหลังพร้อมกัน) ทำให้ Embeddings มีพลังมหาศาลในการทำความเข้าใจภาษาที่ซับซ้อนและล่าสุดอย่าง SONAR: ซึ่งถูกออกแบบมาให้สร้าง Embeddings ที่เป็นตัวแทนของ "แนวคิด" ไม่ใช่แค่คำหรือประโยค ทำให้ LCMs สามารถทำงานได้ตามที่ตั้งใจไว้แล้ว Embeddings กับ LLMs มันทำงานร่วมกันยังไงนะ? ถ้าเปรียบเทียบ LLM เป็นโรงงานผลิตข้อความ Embeddings ก็เหมือนวัตถุดิบชั้นดีที่ถูกส่งเข้าโรงงานนี้

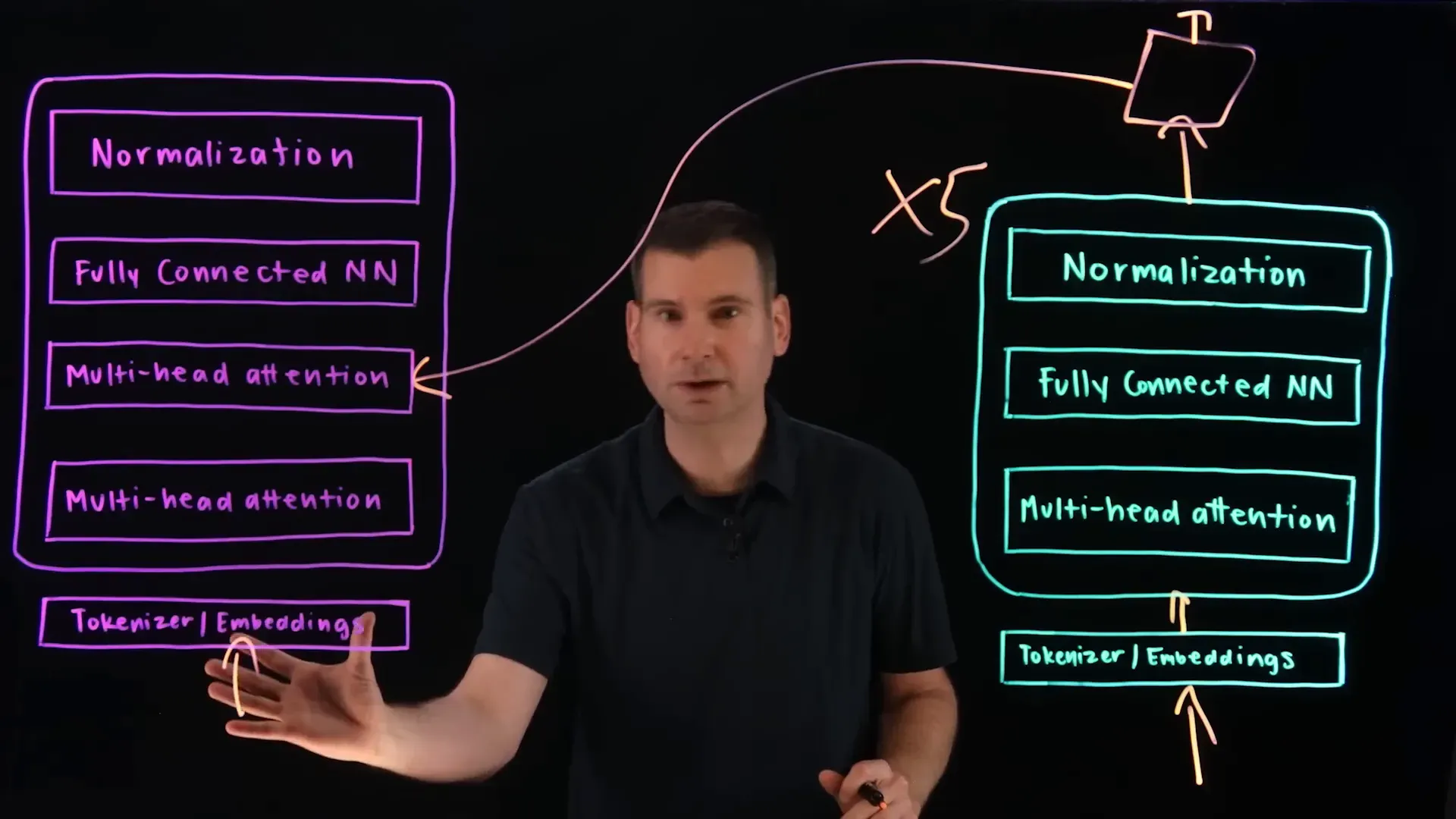

นำเข้าวัตถุดิบ (Embeddings): คำหรือประโยคที่เราป้อนให้ LLM จะถูกแปลงเป็น Embeddings ก่อน ซึ่งเป็นตัวเลขชุดหนึ่งที่ AI เข้าใจได้ผ่านเครื่องจักร "เข้าใจ" (Encoder): ข้อมูล Embeddings เหล่านี้จะเข้าสู่ส่วนที่เรียกว่า Encoder (ตัวเข้ารหัส) ซึ่งมีหลายชั้น มันเหมือนกับสมองส่วนที่ประมวลผลและทำความเข้าใจข้อมูลที่เข้ามามีระบบ "เน้นจุดสำคัญ" (Attention Mechanism): ในระหว่างที่ข้อมูลอยู่ใน Encoder (และใน Decoder ด้วย) จะมีกลไกพิเศษที่เรียกว่า Attention คอยช่วยให้โมเดลรู้ว่าควรให้ความสำคัญกับคำหรือส่วนไหนของประโยคมากกว่ากัน เหมือนเราอ่านข้อความยาวๆ แล้วไฮไลท์เฉพาะใจความสำคัญส่งต่อไปส่วน "สร้างสรรค์" (Decoder): ข้อมูลที่ถูกประมวลผลและทำความเข้าใจแล้วจะถูกส่งไปยัง Decoder (ตัวถอดรหัส) ซึ่งทำงานคล้าย Encoder แต่มีหน้าที่สร้างข้อความใหม่ขึ้นมาสร้างผลลัพธ์ (ข้อความ): Decoder ก็ใช้ Attention Mechanism ในการเลือกคำศัพท์ที่เหมาะสมที่สุดที่จะสร้างเป็นข้อความใหม่ที่สมเหตุสมผลและสอดคล้องกับข้อมูลที่ได้รับมาสถาปัตยกรรมแบบ Encoder-Decoder ที่มี Attention นี่แหละ คือหัวใจสำคัญของโมเดลภาษาขนาดใหญ่ยุคปัจจุบันหลายๆ ตัว รวมถึง Transformer Models อันโด่งดังที่เป็นรากฐานของ LLMs อย่าง ChatGPT

ก้าวใหญ่ถัดไป: เมื่อ AI เริ่ม "คิด" เป็นแนวคิด (Language Concept Models) อย่างที่เกริ่นไป LLMs เก่งในการทำนายโทเค็นถัดไปจากโทเค็นก่อนหน้า ซึ่งทำให้มันสร้างข้อความได้ดีมาก แต่ LCMs ต้องการไปไกลกว่านั้น ด้วยการทำนาย "แนวคิด" หรือ "ประโยค" ถัดไป

"แนวคิด" ในที่นี้ไม่ใช่แค่คำศัพท์ แต่เป็นตัวแทนของความคิด ไอเดีย หรือสาระสำคัญในระดับที่สูงขึ้น และที่สำคัญคือ:

ไม่ยึดติดกับภาษา (Language-Agnostic): แนวคิดเรื่อง "ความสุข" ไม่ว่าเราจะพูดเป็นภาษาไทย อังกฤษ หรือภาษาไหนๆ มันก็คือแนวคิดเดียวกันไม่ยึดติดกับรูปแบบข้อมูล (Modality-Agnostic): แนวคิดเรื่อง "แมว" สามารถมาจากรูปภาพแมว เสียงแมว หรือข้อความที่พูดถึงแมวก็ได้การทำงานของ LCMs ก็คือการใช้ Embeddings ที่เป็นตัวแทนของแนวคิด (ไม่ใช่แค่คำ) มาประมวลผล

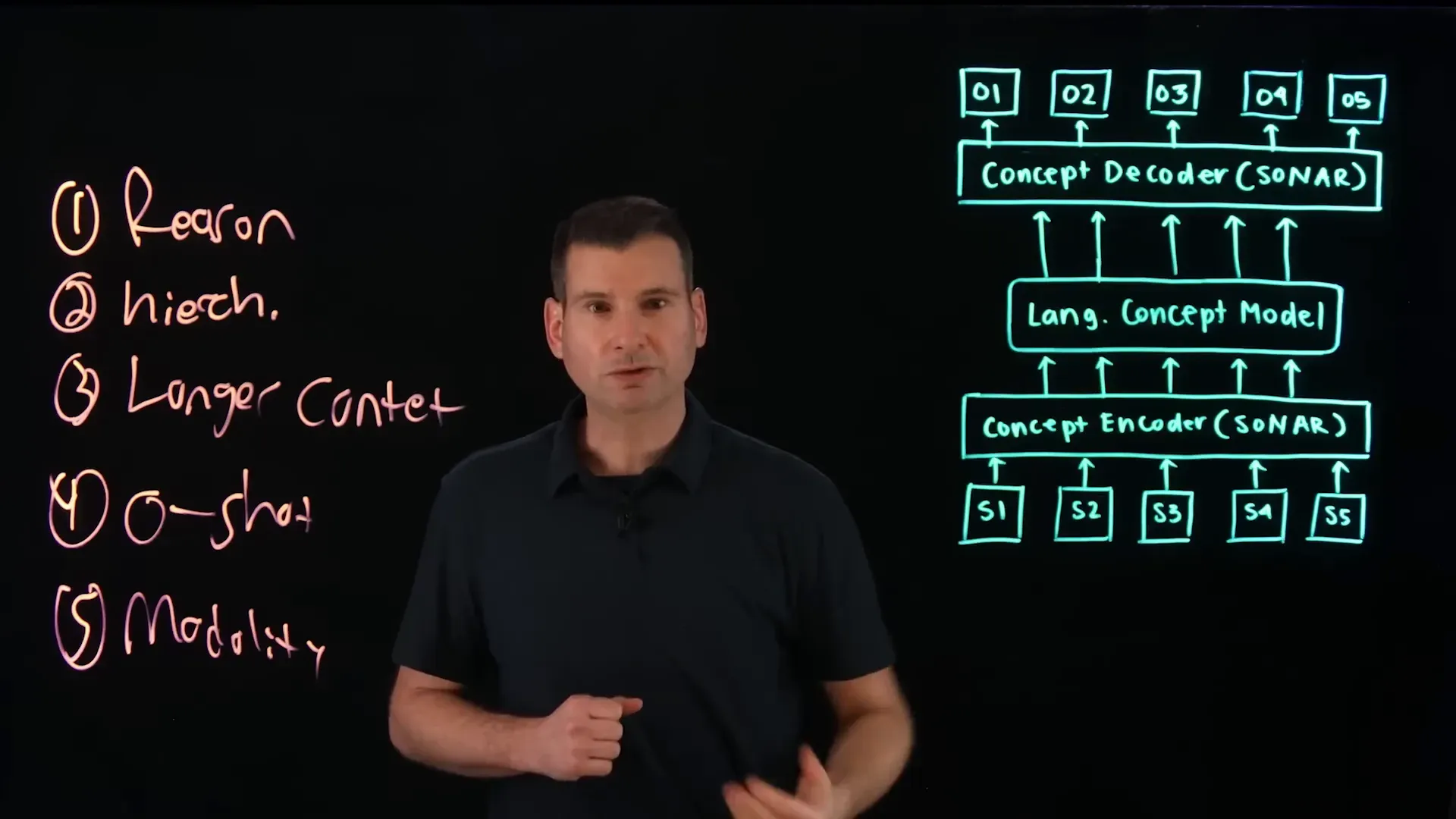

LCMs ทำงานร่วมกับ SONAR Embeddings ได้อย่างไร? โมเดลอย่าง SONAR ที่กล่าวถึงก่อนหน้านี้ ถูกออกแบบมาโดยเฉพาะเพื่อแปลงประโยคหรือข้อความให้กลายเป็น Embeddings ที่ "จับ" เอาแนวคิดของข้อความนั้นๆ ไว้ได้อย่างมีประสิทธิภาพ

กระบวนการทำงานเบื้องต้นของ LCM ที่ใช้ SONAR อาจเป็นแบบนี้:

แปลงเป็นแนวคิด Embeddings: ประโยคหรือข้อมูลที่เข้ามาจะถูกแปลงเป็น Embeddings ที่เป็นตัวแทนของ "แนวคิด" ด้วย SONARทำนายแนวคิดถัดไป: โมเดล LCM จะรับ Embeddings ของแนวคิดเหล่านี้เข้าไป และทำนายว่า "แนวคิด" ถัดไปในลำดับตรรกะควรจะเป็นอะไร Embeddings ของแนวคิดถัดไปก็จะถูกสร้างขึ้นมาแปลงแนวคิดกลับเป็นภาษา: หลังจากได้ Embeddings ของแนวคิดที่ทำนายได้ SONAR ก็จะทำหน้าที่ย้อนกลับ โดยแปลง Embeddings ของแนวคิดนั้นๆ ให้กลายเป็นประโยคหรือข้อความที่มนุษย์เข้าใจได้การทำงานในระดับแนวคิดแบบนี้ ช่วยให้ AI เข้าใจลำดับขั้นของข้อมูลที่ซับซ้อน และคิดในเชิงนามธรรมได้ดีขึ้น

เทคนิคขั้นสูง: Diffusion-Based LCMs กับการกลั่นกรองแนวคิด หนึ่งในแนวทางที่น่าสนใจในการพัฒนา LCMs คือการนำเทคนิคที่เรียกว่า Diffusion Model มาใช้ ซึ่งเทคนิคนี้โด่งดังมากจากการสร้างรูปภาพ AI ที่สมจริง

ลองนึกภาพการสร้างภาพ AI ด้วย Diffusion: มันมักจะเริ่มจากภาพที่มี Noise หรือความเบลอมากๆ แล้วค่อยๆ ลด Noise ลงทีละน้อย จนได้ภาพที่คมชัดสมจริง

แนวคิดนี้ถูกนำมาปรับใช้กับ LCMs โดย:

แทนที่จะเป็นภาพ Diffusion LCMs จะทำงานกับ Embeddings ของแนวคิด กระบวนการคือการค่อยๆ ลด Noise หรือความไม่แน่นอนออกจาก Embeddings ของ "แนวคิดที่เป็นไปได้" โมเดลจะเริ่มต้นจาก Embeddings แนวคิดที่ค่อนข้างคลุมเครือ มี Noise สูง แล้วค่อยๆ ปรับแต่ง กลั่นกรอง จนได้ Embeddings ที่เป็นตัวแทนของ "แนวคิดที่ถูกต้องและชัดเจนที่สุด" ในบริบทนั้นๆ การใช้ Diffusion Model ช่วยให้ LCMs สามารถทำนายแนวคิดได้อย่างแม่นยำและน่าเชื่อถือมากขึ้น โดยมักจะใช้สถาปัตยกรรมแบบ two-tower architecture โดยมีส่วนหนึ่งทำหน้าที่ ลด Noise (denoiser) และอีกส่วนทำหน้าที่ "ถอดรหัส" (decoder) แนวคิดที่ได้ออกมา

ทำไม Language Concept Models (LCMs) ถึงสำคัญและนำไปใช้อะไรได้บ้าง? การก้าวจาก LLMs ที่เน้นโทเค็น มาสู่ LCMs ที่เน้นแนวคิดนี้ เปิดประตูสู่ความสามารถใหม่ๆ ที่น่าตื่นเต้นของ AI:

คิดได้นามธรรมขึ้น: AI ไม่ได้ติดอยู่แค่กับคำศัพท์ แต่เข้าใจแก่นของเรื่อง ทำให้วิเคราะห์และประมวลผลข้อมูลได้ลึกซึ้งกว่าเดิม เช่น เข้าใจ "เจตนารมณ์" ของกฎหมาย หรือ "อารมณ์ขัน" ที่ซ่อนอยู่ในบทสนทนาจัดการข้อมูลซับซ้อนเป็นลำดับชั้น: เหมือนที่สมองคนเราจัดเรียงข้อมูลเป็นหมวดหมู่และความสัมพันธ์เชิงตรรกะ LCMs ก็สามารถวิเคราะห์โครงสร้างของข้อมูลที่มีความซับซ้อน เช่น สรุปเนื้อหาหนังสือทั้งเล่ม หรือวิเคราะห์โครงสร้างการโต้แย้งในการอภิปรายได้ประมวลผลข้อมูลยาวๆ และหลากหลายรูปแบบ: ด้วยการทำงานในระดับแนวคิดที่กระชับกว่าการมองทีละโทเค็น ทำให้ LCMs จัดการกับข้อมูลที่มีความยาวมากๆ ได้ดีขึ้น และที่สำคัญคือ Modality-Agnostic ทำให้ AI สามารถเชื่อมโยงและทำความเข้าใจแนวคิดที่มาจากแหล่งข้อมูลต่างกันได้พร้อมๆ กัน ไม่ว่าจะเป็น ข้อความ เสียง ภาพ หรือแม้แต่วิดีโอสร้างสรรค์เนื้อหาแบบ Zero-Shot ได้เก่งขึ้น: ด้วยความเข้าใจในระดับแนวคิด AI สามารถสร้างข้อความหรือเนื้อหาตามที่ต้องการได้โดยไม่ต้องเคยเห็นตัวอย่างที่เป๊ะๆ มาก่อนจำนวนมาก เพราะมันเข้าใจ "แนวคิด" ของสิ่งที่เราขอ เช่น สั่งให้เขียนบทกวีเกี่ยวกับ "ความเหงาในเมืองใหญ่" โดยไม่ต้องเคยเห็นบทกวีแบบนี้มาก่อนเลยยืดหยุ่นในการใช้งาน: ความเป็น Modality-Agnostic ทำให้ LCMs เป็นพื้นฐานที่ดีในการพัฒนาระบบ AI ที่สามารถรับอินพุตได้หลายแบบ และให้เอาต์พุตได้หลายแบบ ตอบโจทย์การใช้งานที่หลากหลายในชีวิตประจำวันและในภาคธุรกิจบทสรุปจาก Insiderly การเกิดขึ้นและการพัฒนาของ Language Concept Models หรือ LCMs ถือเป็นวิวัฒนาการที่สำคัญของ Generative AI อย่างแท้จริง เรากำลังเปลี่ยนผ่านจากการมี AI ที่เก่งกาจในการเลียนแบบรูปแบบภาษา ไปสู่ AI ที่เริ่มมีความสามารถในการ "เข้าใจ" และ "คิด" ในระดับที่ลึกซึ้งและเป็นนามธรรมมากขึ้น

การทำงานในระดับแนวคิดนี้ ไม่เพียงแต่ทำให้ AI จัดการกับความซับซ้อนของภาษาและข้อมูลได้ดีขึ้น แต่ยังปูทางไปสู่ระบบ AI ที่มีความยืดหยุ่น สามารถเรียนรู้และปรับตัวเข้ากับข้อมูลรูปแบบใหม่ๆ ได้ง่ายขึ้น ความสามารถในการเชื่อมโยงแนวคิดข้ามรูปแบบข้อมูล (Modality-Agnostic) จะเป็นกุญแจสำคัญในการสร้าง AI ที่สามารถโต้ตอบและช่วยเหลือมนุษย์ในโลกแห่งความเป็นจริงที่เต็มไปด้วยข้อมูลหลากหลายรูปแบบ

LCMs เป็นสัญญาณที่ชัดเจนว่า AI กำลังก้าวเข้าใกล้การมีความเข้าใจโลกในแบบที่เราเป็นอยู่ ซึ่งจะนำไปสู่แอปพลิเคชันและนวัตกรรมใหม่ๆ ที่เราอาจยังนึกไม่ถึง เป็นอนาคตของ AI ที่น่าจับตาอย่างยิ่ง และจะทำให้ AI กลายเป็นผู้ช่วยที่ชาญฉลาดและพึ่งพาได้มากขึ้นในทุกๆ ด้านของชีวิต

คำศัพท์เทคนิคที่ควรรู้ Token: หน่วยพื้นฐานของภาษาที่โมเดล AI ประมวลผล อาจเป็นคำทั้งคำ ส่วนหนึ่งของคำ หรือแม้แต่เครื่องหมายวรรคตอนEmbedding: กระบวนการแปลงคำ ประโยค หรือแนวคิด ให้เป็นเวกเตอร์ของตัวเลขในพื้นที่หลายมิติ เพื่อให้คอมพิวเตอร์สามารถวิเคราะห์และเปรียบเทียบความหมายได้Cosine Similarity: วิธีการวัดความคล้ายคลึงกันระหว่างเวกเตอร์สองตัว โดยดูจากมุมระหว่างเวกเตอร์นั้นๆ (ค่าใกล้ 1 คือคล้ายกันมาก ใกล้ -1 คือตรงข้ามกัน ใกล้ 0 คือไม่เกี่ยวข้องกัน)Encoder-Decoder Architecture: โครงสร้างพื้นฐานของโมเดลภาษาหลายๆ ตัว โดยส่วน Encoder ทำหน้าที่รับและประมวลผลข้อมูลอินพุต ส่วน Decoder ทำหน้าที่สร้างข้อมูลเอาต์พุตAttention Mechanism: กลไกในโมเดล AI ที่ช่วยให้โมเดลรู้ว่าจะต้อง "ให้ความสนใจ" หรือเน้นส่วนไหนของข้อมูลอินพุตเป็นพิเศษในการประมวลผลแต่ละขั้นตอนMulti-Headed Attention: การใช้ Attention Mechanism หลายชุดทำงานพร้อมกัน เพื่อให้โมเดลสามารถจับความสัมพันธ์และความสำคัญของข้อมูลได้หลากหลายมิติและมุมมองในคราวเดียวDiffusion Model: โมเดลสร้างสรรค์ (Generative Model) ที่ทำงานโดยการค่อยๆ เพิ่ม Noise ให้กับข้อมูลจริงจนกลายเป็น noise ล้วนๆ ในขั้นตอนการฝึก และเรียนรู้วิธีการ "ลด Noise" เพื่อแปลงจาก noise กลับมาเป็นข้อมูลจริงในขั้นตอนการสร้างModality-Agnostic: ความสามารถของโมเดล AI ในการทำงานกับข้อมูลได้หลากหลายรูปแบบ (modalities) เช่น ข้อความ รูปภาพ เสียง หรือวิดีโอ โดยไม่จำกัดว่าจะต้องเป็นรูปแบบใดรูปแบบหนึ่งเท่านั้นZero-Shot Generation: ความสามารถของโมเดล AI ในการสร้างเนื้อหา ตอบคำถาม หรือทำงานตามคำสั่งที่ไม่เคยเห็นตัวอย่างมาก่อน (หรือเห็นน้อยมาก) โดยอาศัยความเข้าใจใน "แนวคิด" หรือ "ความหมาย" ของสิ่งนั้นๆSONAR: คือชื่อของเทคโนโลยีการสร้าง Embeddings ที่เป็นตัวแทนของแนวคิด ใช้เป็นส่วนประกอบสำคัญใน LCMs เพื่อแปลงแนวคิดเป็นเวกเตอร์และแปลงกลับที่มา : VIDEO