Introducing GPT-5: ก้าวใหม่ของ AI ที่ฉลาดและเก่งกว่าเดิม

พบกับ GPT-5 รุ่นล่าสุดจาก OpenAI ที่พัฒนา AI ให้ฉลาดขึ้น รวดเร็วขึ้น และน่าเชื่อถือมากกว่าเดิม พร้อมความสามารถ reasoning, การสร้างซอฟต์แวร์ และใช้งานฟรีผ่าน ChatGPT

Riccardo Loconte ได้ทดลองใช้ AI ในการจับโกหก เทียบกับความแม่นยำของมนุษย์ในการตรวจจับโกหก และโอกาสของเทคโนโลยี AI ในอนาคตที่เปลี่ยนแปลงโลกของเรา

การโกหกเป็นสิ่งที่เกิดขึ้นในชีวิตประจำวันของมนุษย์อย่างหลีกเลี่ยงไม่ได้ นักวิทยาศาสตร์ประเมินว่าเราโกหกเฉลี่ยวันละประมาณสองครั้ง แม้ว่าจะยากที่จะกำหนดตัวเลขนี้อย่างแม่นยำ แต่สิ่งที่ชัดเจนคือมนุษย์ไม่เก่งในการจับโกหกเลย และนี่คือจุดเริ่มต้นของการศึกษาที่น่าสนใจเกี่ยวกับการใช้ AI ในการตรวจจับความจริงและความเท็จในคำพูดของคน

การรู้ว่าคนอื่นโกหกหรือพูดความจริงมีความสำคัญในหลายบริบท ตัวอย่างแรกที่ชัดเจนคือในงานสืบสวนสอบสวนของตำรวจ เมื่อตำรวจสัมภาษณ์ผู้ต้องสงสัย ข้อมูลที่ได้รับจะนำไปสู่ขั้นตอนต่อไปของการสืบสวน ดังนั้นการรู้ว่าผู้ต้องสงสัยพูดจริงหรือโกหกจึงมีผลโดยตรงต่อความสำเร็จของคดี

นอกจากนี้ เรื่องนี้ยังเกี่ยวข้องกับชีวิตประจำวันของทุกคนด้วย เช่น ความสงสัยว่าคู่รักของเราจะนอกใจหรือไม่ ซึ่งเป็นเรื่องที่หลายคนอยากรู้ แต่ปัญหาคือมนุษย์เองก็ไม่เก่งในการจับโกหกเท่าไหร่

งานวิจัยหลายชิ้นยืนยันว่ามนุษย์เมื่อถูกถามให้ตัดสินว่าใครโกหกหรือไม่ โดยไม่รู้ข้อมูลบริบทหรือเกี่ยวกับคนนั้นมากนัก ผลการตัดสินของเรามักจะไม่ต่างจากการโยนเหรียญเลย คือประมาณ 50% เท่านั้น

แม้แต่ผู้เชี่ยวชาญ เช่น ตำรวจ นักกฎหมาย หรือแม้แต่นักจิตวิทยา ก็ไม่ได้มีความแม่นยำมากกว่าคนทั่วไปเท่าไหร่ จากการวิเคราะห์ผลการทดลอง 108 งานวิจัยในปี 2006 พบว่าคนธรรมดามีความแม่นยำประมาณ 54% ในขณะที่ผู้เชี่ยวชาญได้แค่ 55% เท่านั้น ซึ่งถือว่าไม่ดีเลยสำหรับการตัดสินความจริงจังหรือไม่ในคำพูดของผู้อื่น

แล้วถ้าเรามี AI ที่ช่วยจับโกหกล่ะ? คำตอบคือในปัจจุบันยังไม่มี AI ที่สมบูรณ์แบบสำหรับงานนี้ แต่มีงานวิจัยที่น่าสนใจโดยทีมงานของ Riccardo Loconte ซึ่งได้ใช้เทคนิคที่เรียกว่า “fine tuning” เพื่อเทรน AI ให้จับโกหกได้ในบางบริบท

“Large language models” หรือโมเดลภาษาใหญ่ คือระบบ AI ที่ถูกออกแบบมาเพื่อสร้างข้อความที่เหมือนมนุษย์พูดคุยกัน แต่อย่างไรก็ตาม การทำให้ AI เหล่านี้มีความเชี่ยวชาญในงานเฉพาะ เช่น การจับโกหก ต้องใช้การเทรนเพิ่มเติมที่เจาะจงกว่าการเรียนรู้ทั่วไปเหมือนนักเรียนที่เรียนจบปริญญาตรีแล้วต้องไปเรียนต่อเฉพาะทาง

การเทรน AI จำเป็นต้องใช้ชุดข้อมูลที่มีทั้งข้อความจริงและข้อความที่โกหก เพื่อให้ AI เรียนรู้ความแตกต่าง อย่างในงานวิจัยนี้ใช้ชุดข้อมูลสามชุดหลัก ได้แก่ ข้อความเกี่ยวกับความคิดเห็นส่วนตัว, ความทรงจำในอดีต และเจตนาในอนาคต

ตัวอย่างเช่น ในชุดข้อมูลเกี่ยวกับความทรงจำในอดีต ผู้เข้าร่วมจะถูกขอให้เล่าประสบการณ์วันหยุดที่ผ่านมาอย่างจริงใจ หรือในเงื่อนไขโกหกจะถูกขอให้แต่งเรื่องขึ้นมาและพยายามโน้มน้าวให้คนอื่นเชื่อว่ามันเป็นเรื่องจริง เช่น บอกว่าตนเคยไปเที่ยวเวียดนาม ทั้งที่จริงๆ ไม่เคยไป

หลังจากเทรน AI ด้วยชุดข้อมูลเหล่านี้แล้ว จะมีการทดสอบ AI ด้วยชุดข้อมูลที่ AI ไม่เคยเห็นมาก่อน เพื่อดูว่า AI สามารถแยกแยะความจริงและโกหกได้ดีแค่ไหน เหมือนการสอบปลายภาคของนักเรียนที่ต้องทำข้อสอบใหม่โดยไม่เคยเห็นข้อสอบนี้มาก่อน

ในงานวิจัยนี้ใช้โมเดลที่ชื่อว่า FLAN-T5 (หรือเรียกเล่นๆ ว่า “Flanny”) ซึ่งเป็นโมเดลภาษาใหญ่ที่พัฒนาโดย Google

งานวิจัยแบ่งเป็น 3 การทดลองหลัก:

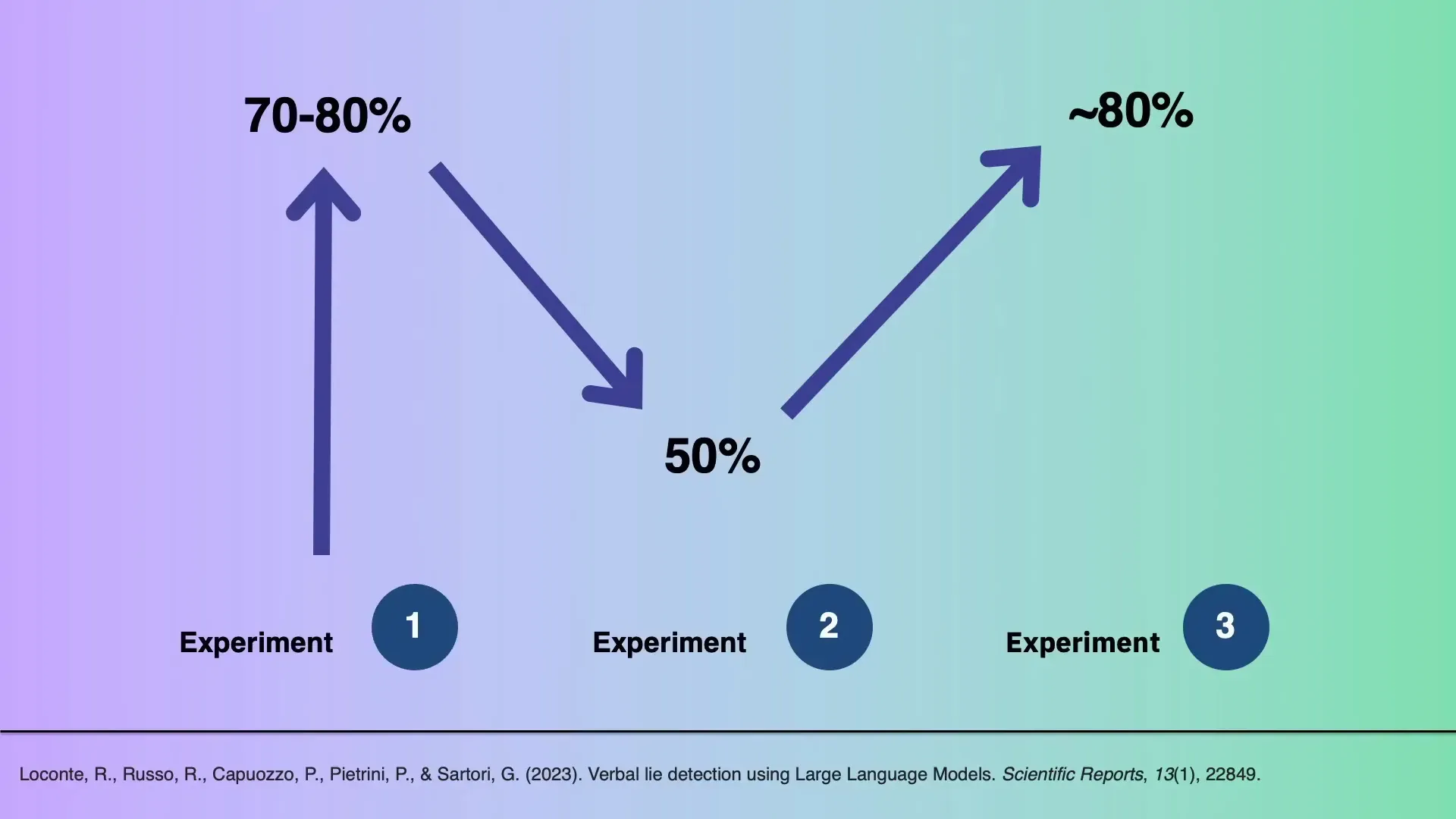

ผลลัพธ์พบว่า ในการทดลองแรกและสาม โมเดล FLAN-T5 สามารถจับโกหกได้แม่นยำถึง 70-80% ซึ่งดีกว่ามนุษย์อย่างชัดเจน

แต่ในการทดลองที่สอง โมเดลทำได้แค่ประมาณ 50% เท่านั้น ซึ่งเท่ากับการเดาแบบสุ่ม นี่แสดงให้เห็นว่า AI ยังมีปัญหาในการนำความรู้ที่เรียนจากบริบทหนึ่งไปใช้กับอีกบริบทหนึ่ง เพราะการโกหกนั้นมีลักษณะขึ้นอยู่กับบริบทและสถานการณ์ที่แตกต่างกัน

ผลการทดลองชี้ให้เห็นว่า AI สามารถช่วยตรวจจับโกหกได้ดีในบริบทที่ได้รับการเทรนมาดีพอ แต่ยังต้องการการพัฒนาและทดสอบเพิ่มเติมก่อนจะนำไปใช้จริงในชีวิตประจำวัน

ลองจินตนาการถึงโลกที่เทคโนโลยีตรวจจับโกหกด้วย AI ถูกนำมาใช้ในหลายด้าน เช่น

อย่างไรก็ตาม เทคโนโลยีนี้ยังมีความเสี่ยง หากผู้คนเชื่อ AI อย่างไม่ตั้งคำถาม อาจทำให้เกิดการกล่าวหากันโดยไม่มีมูล และทำลายความไว้วางใจในสังคม เพราะการพึ่งพา AI มากเกินไปอาจทำให้มนุษย์ละเลยการคิดวิเคราะห์และตัดสินใจด้วยตนเอง

สิ่งที่ผู้วิจัยเน้นคือ AI ควรไม่ใช่แค่บอกว่าใครโกหกหรือไม่ แต่ควรอธิบายเหตุผลและหลักฐานที่ทำให้ AI ตัดสินใจเช่นนั้น เหมือนกับรีวิวร้านอาหารที่ไม่ใช่แค่ให้ดาว แต่ยังมีรีวิวบอกว่าจุดเด่นและจุดด้อยของร้านคืออะไร เพื่อให้ผู้ใช้สามารถตัดสินใจด้วยตัวเองได้

โลกอนาคตที่น่าจะเป็นคือโลกที่ AI เป็นเครื่องมือเสริมสร้างความเข้าใจและช่วยให้มนุษย์ตัดสินใจได้ดีขึ้น ไม่ใช่เป็นผู้ตัดสินแทนมนุษย์อย่างสิ้นเชิง

การใช้ AI ในการตรวจจับความจริงและความเท็จเป็นการก้าวหน้าทางเทคโนโลยีที่น่าตื่นเต้นและมีศักยภาพสูง ผลการวิจัยชี้ให้เห็นว่า AI สามารถทำงานนี้ได้ดีกว่ามนุษย์ในบางบริบท แต่ยังมีข้อจำกัดในเรื่องการปรับใช้ข้ามบริบทที่แตกต่างกัน

ความท้าทายที่สำคัญคือการรักษาสมดุลระหว่างการใช้ AI เพื่อช่วยในการตัดสินใจและการรักษาความสามารถในการคิดวิเคราะห์ของมนุษย์ ไม่ควรปล่อยให้ AI กลายเป็นผู้ตัดสินแทนทั้งหมด เพราะนั่นอาจนำไปสู่ความเสี่ยงของการสูญเสียความไว้วางใจและการพึ่งพาเทคโนโลยีอย่างไม่ลึกซึ้ง

ดังนั้นอนาคตของ AI ในการตรวจจับโกหกจึงไม่ใช่แค่เรื่องของเทคโนโลยี แต่เป็นเรื่องของการพัฒนาเครื่องมือที่ช่วยเสริมสร้างความเข้าใจและความเชื่อมั่นระหว่างมนุษย์ด้วยกันเองและกับเทคโนโลยี

การพัฒนา AI ที่โปร่งใส อธิบายเหตุผลได้ และยังคงส่งเสริมให้ผู้ใช้คิดวิเคราะห์เองได้ จะเป็นกุญแจสำคัญที่จะทำให้เทคโนโลยีนี้เป็นประโยชน์จริงในสังคม